Proyectos

En esta sección puedes hacer dos cosas: leer cuatro palabras sobre algunos proyectos en los que trabajo o he trabajado, y mandarme comentarios sobre ellos (¡o sobre cualquier otra cosa!). Así que ve al apartado de comentarios o elige entre los siguientes temas:

- Wikiparable, corpus de la Wikipedia

- TACARDI, Traducción automática en contexto y aumentada con recursos dinámicos de Internet

- OPENMT-2, Traducción automática híbrida y evaluación avanzada

- MOLTO, Multilingual On-Line Translation

- Aprendizaje en Traducción Automática Estadística

- COCO, la COmpilación de COrpus de Text-Mess

- Traducción automática de subtítulos Inglés-Catalán

- Descobrim l'Univers

Wikiparable, corpus de la Wikipedia

Wikipedia es una fuente de información multilingüe muy valiosa. Actualmente la enciclopedia cubre casi 300 lenguas y su estructura con enlaces entre wiquipedias permite establecer correspondencias entre las diferentes ediciones de un mismo artículo. Aunque el porcentaje de artículos coincidentes entre lenguas es muy bajo (sólo un 7% para las tres ediciones más grandes: inglés, alemán y francés) se pueden obtener textos comparables para una gran cantidad de lenguas.

Dentro de esta línea trabajamos en tres direcciones. Por un lado, trabajamos en la adquisición de corpus comparables para dominios concretos, por otro en la extracción de corpus paralelos a partir de los corpus comparables. Finalmente, desarrollamos una interfaz web para facilitar el enriquecimiento de wiquipedias: ediciones menos completas se pueden beneficiar de la información relevante presente en otras ediciones. Para cumplir estos propósitos utilizamos técnicas tanto de recuperación de información (translingüe cuando es necesario) como de traducción automática.

TACARDI, Traducción automática en contexto y aumentada con recursos dinámicos de Internet

Con el objetivo principal de lograr mejoras cualitativas en los sistemas de traducción automática del estado del arte, TACARDI se centra en las siguientes dos líneas de investigación:

La explotación de los nuevos recursos que ofrece Internet. (i) El enriquecimiento de los recursos orientados a la traducción automática: por ejemplo, el uso de corpus comparables recolectados de forma automática a través de Internet, y la recolección de léxicos especializados utilizando Wikipedia y sus metadatos (entidades, términos de varias palabras, categorías, enlaces multilingües, etc.). (ii) Recopilación de información multilingüe on-line para mejorar la traducción, sobre todo en palabras desconocidas, por ejemplo mediante el acceso a fuentes de información multilingüe que se actualizan con mucha frecuencia (Twitter, Wikipedia, noticias, etc.).

Ampliación de la información contextual utilizada en la traducción más allá de la frase. (i) Traducción a nivel de documento (no frase por frase). Esta metodología dará lugar a traducciones globales de documentos que muestran una coherencia discursiva mejor. Por ejemplo, ésto se consigue mediante la traducción de una manera coherente de todos los términos que se co-referencian en un documento. (ii) La explotación de meta-información no textual disponible en los documentos. Por ejemplo mediante el uso de etiquetas temáticas o de dominio, información extraída de los enlaces a las webs, o, en el caso del texto de las aplicaciones de software, el contexto en el que aparece (la traducción puede variar drásticamente si el texto aparece en un párrafo, un enlace, un botón, o un menú). Esta línea de investigación podría mejorar la selección léxica y la adaptación de dominio de los sistemas de traducción actuales.

Con el fin de evaluar la evolución de las líneas de investigación anteriores el proyecto trabajará con textos de tres dominios diferentes de aplicación: artículos de Wikipedia, mensajes de Twitter y software (localización y traducción de manuales de usuario). Se han aplicado ya herramientas de traducción a estos tres casos, obteniendo beneficios significativos. Este proyecto tiene como objetivo proporcionar mejoras capaces incluso de tener un impacto positivo mayor en MT a corto y medio plazo.

(Del resumen oficial del proyecto)TIN2012-38523-C02-00 (01/02/2013-31/01/2016)

MOLTO, Multilingual On-Line Translation

El objetivo de MOLTO es desarrollar un conjunto de herramientas para traducir textos entre varios idiomas en tiempo real y con alta calidad. Las lenguas son módulos separados en la herramienta y por tanto se pueden cambiar, los prototipos que se construirán cubrirán la mayor parte de los 23 idiomas oficiales de la UE.

Como técnica principal, MOLTO utiliza gramáticas semánticas de dominio específico y interlingua basadas en ontologías. Estos componentes se implementan en GF (Grammatical Framework), un formalismo de gramáticas donde se relacionan varios idiomas a través de una sintaxis abstracta común. El GF se ha aplicado en varios dominios de tamaño pequeño y mediano, típicamente para tratar hasta un total de diez idiomas, pero MOLTO ampliará esto en términos de productividad y aplicabilidad.

Parte de la ampliación se dedicará a aumentar el tamaño de los dominios y el número de idiomas. Una parte importante es hacer que la tecnología sea accesible para expertos del dominio sin experiencia con GFs y reducir al mínimo el esfuerzo necesario para la construcción de un traductor. Idealmente, esto se puede hacer sólo extendiendo un lexicón y escribiendo un conjunto de frases de ejemplo.

Las partes con investigación más intensiva de MOLTO son la interoperabilidad en los dos sentidos entre estándares de ontologías (OWL) y las gramáticas GF, y la extensión de las traducciones basadas en reglas con métodos estadísticos. La interoperabilidad OWL-GF permitirá la interacción multilingüe basada en lenguaje natural con conocimiento válido para las máquinas. Los métodos estadísticos añadirán robustez al sistema. Se desarrollarán nuevos métodos para combinar las gramáticas GF con la traducción estadística en beneficio de ambos.

La tecnología de MOLTO será entregada como librerías de código abierto que podrán ser conectadas a las herramientas de traducción estándar y páginas web y, por tanto, podrán ser integradas en los flujos de trabajo estándar. Se crearán demos web y se aplicará en tres estudios de caso: ejercicios de matemáticas en 15 idiomas, datos de patentes en al menos 3 idiomas, y descripciones de objetos de museos en 15 idiomas.

(Del resumen oficial del proyecto)FP7-ICT-247914 (01/03/2010-31/08/2013)

OPENMT-2, Traducción automática híbrida y evaluación avanzada

El objetivo del proyecto OpenMT-2 es fomentar la investigación en tecnología de traducción automática (MT) con el fin de generar sistemas de traducción automática híbrida robusta y de alta calidad, y la mejora de las métricas y metodologías de evaluación. OpenMT-2 parte de la investigación previa llevada a cabo en el marco del proyecto OpenMT de los años 2006-2008 (TIN2006-15307-C03-01).

La investigación en OpenMT-2 se lleva a cabo en 5 áreas principales: (i) Recolección, anotación y explotación de corpus multilingüe, (ii) Mejora de los sistemas actuales de traducción de un solo paradigma, (iii) Pre-edición, post-edición y mejora del sistema basados en la colaboración con la comunidad web2.0, (iv) Combinación e hibridación de diversos paradigmas de MT, y (v) Evaluación avanzada de MT.

Se comprobará la funcionalidad de la nueva tecnología y de los sistemas desarrollados con cuatro idiomas diferentes: Inglés, Castellano, Catalán y Euskera. Además, los sistemas se aplicarán en diferentes contextos (es decir, corpora de diferentes dominios y géneros).

El consorcio está compuesto por dos universidades: la Universidad del País Vasco (UPV/EHU), y la Universidad Politécnica de Catalunya (UPC); y un centro de investigación sin ánimo de lucro: Elhuyar. Varias empresas y fundaciones con actividades en áreas estrechamente relacionadas servirán como EPOs de supervisión para el proyecto: Eleka, Fundació i2CAT, Imaxin, Semantix, Translendium SL y eu.wikipedia.

(Del resumen oficial del proyecto)TIN2009-14675-C03-01 (01/01/2010-31/12/2012)

Aprendizaje en Traducción Automática Estadística

La traducción automática estadística es uno de los paradigmas con más exito en traducción automática, pero todavía muestra ciertas limitaciones. Como los sistemas traducen segmento a segmento (o phrase a phrase) no aprovechan toda la información que esconde la frase. ésto se puede solucionar utilizando técnicas de aprendizaje automático que permitan aprender a clasificar la traducción de un segmento según el contexto en que se encuentre (i.e. las palabras que lo rodean) o la sintaxis de la oración por ejemplo.

Actualmente trabajamos en la integración de las dos aproximaciones. Cada vez que el sistema tiene que elegir la traducción de un segmento usa las características asociadas a cada posible traducción para elegirla. Entre estas características se pueden incluir tanto las probabilidades utilizadas en un modelo estándard de traducción automática estadística como atributos que describan la categoría gramatical de la phrase, el part-of-speech, la posición dentro de la oración, las palabras que la rodean, etc.

Como he dicho en otro sitio de la web, el grup de investigación en traducción automática en el GPLN está formado por Jesús Giménez, Lluís Màrquez y yo misma. El estado del trabajo se puede ir siguiendo en nuestra wiki: EMTwiki!

COCO, la COmpilación de COrpus de Text-Mess

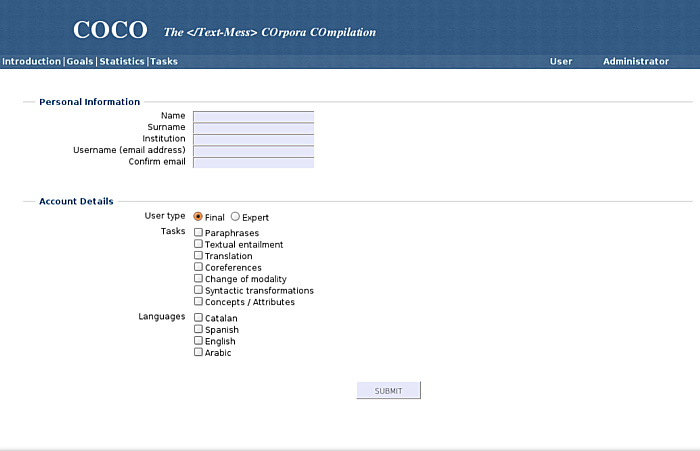

COCO es una interfaz web pensada para adquirir conocimiento a partir de la información que introduzcan voluntarios, y es un subproyecto dentro de Text-mess. Mi aportación está siendo la implementación de la interfaz, el nuclio de la cual utiliza MySQL y PHP. En la primera fase COCO permite tratar, ampliar y validar corpus de paráfrasis. Si quieres formar parte de estos voluntarios puedes visitar la web y contribuir! Si sólo quieres chafardear el aspecto que tiene aquí te dejo unas muestras:

En breve el número de tareas disponibles se ampliará para acabar recopilando corpus de:

- Pares de paráfrasis

- Pares de implicaciones textuales

- Correferencias

- Cambios de modalidad de oraciones

- Transformaciones sintácticas

- Atributos de conceptos

Este trabajo se está llevando a cabo conjuntamente entre el Departament de Llenguajes i Sistemes Informàtics de la UPC (LSI) i el Centre de Llenguatge i Computació de la UB (CLiC).

Traducción automática de subtítulos Inglés-Catalán

Este es un proyecto que hace tiempo que me ronda por la cabeza pensado para que los aficionados catalanes al cine en versión original tengan la ayuda de los subtítulos en su lengua o para facilitar su aprenendizaje a no catalanohablantes. Encontrar subtítulos en la web es extremadamente fácil para las lenguas mayoritarias como el castellano o el inglés pero es bastante más complicado para el catalán.

La idea básica es tratar de utilizar un sistema estándard de traducción automática estadística (Moses) para hacer la traducción de subtítulos al catalán de forma automatizada. Estos sistemas traducen textos nuevos a base de la información que han obtenido de traducciones ya vistas. Para entrenarlos es necesario disponer de textos alineados frase a frase en els dos idiomas. Si después los fragmentos a traducir pertenecen al mismo dominio que estos documentos alineados las traducciones serán en general buenas.

Por una parte, la traducción de subtítulos puede ser complicada porque se trata de frases a veces demasiado cortas. Por otra parte, películas o series de un mismo género comparten vocabulario y expresiones, y eso puede facilitar la traducción en algunos casos. Un sistema entrenado con les tres primeras temporadas de Prison Break, ahora estaría traduciendo de manera acceptable la cuarta temporada pero no podría traducir House M.D. por ejemplo; un sistema entrenado únicamente con las películas de Tim Burton no sería eficiente traduciendo Los Simpson, etc. La clave está pues en tener una base de datos inicial (corpus) variada y como más amplia mejor. Una vez se dispone de estos datos el sistema se puede ampliar y especializar rápidamente para los diferentes géneros.

Pero conseguir este corpus inicial no es el único problema, hay que conseguir que los subtítulos en las dos lenguas se correspondan frase a frase y ésto no siempre ocurre. Actualmente dispongo de un centenar de subtítulos en las dos llenguas, catalán e inglés. Con un promedio de 500 líneas por película, únicamente se dispone de unos 50.000 pares de frases. Esto es un corpus relativamente pequeño, pero aún así, el hecho de vigilar que las frases se correspondan frase a frase en los dos idiomas es bastante lento y por eso el proyecto se trata sólo de una idea de momento...

No hace falta decir que cualquier ayuda será bienvenida. Si dispones de pares de subtítulos me los puedes mandar por correo o si quieres colaborar a alinear pares existe programario que facilita el trabajo (Gaupol para linux o Subtitle Workshop para windows, por ejemplo). ¡Ponte en contacto conmigo para más información!

Descobrim l'Univers

Descobrim l'Univers (Descubramos el Universo) es una actividad integrada en la oferta de divulgación y educación del Centre d'Observació de l'Univers (COU) del Parc Astronòmic del Montsec. Está pensada para estudiantes de entre 11 y 14 años que visitan el COU y hacen una primera aproximación a la cosmología. Incluye un dossier para los alumnos y uno para los profesores que giran entorno lo que se explica en un vídeo de 15 minutos de duración. En esta sección puedes ver este vídeo Flash que hice con Andreu Balastegui y que explica la historia del Universo desde que empieza la expansión hasta la actualidad. La narración es a cargo del periodista Pep Gorgori. Sé benévolo, el vídeo es del 2004 y fue nuestra primera experiencia con Flash!

Si quieres entretenerte un poco puedes darle un vistazo al dossier también: